生成式AI解决的是“模型规模与算力密度”的匹配问题,本质上围绕训练效率与推理吞吐展开;而Agentic AI解决的则是“系统级实时协同”的问题,其核心从单模型能力转向多模块闭环协作。

在生成式阶段,行业关注的是:

GPU FLOPS峰值

HBM带宽规模

大模型参数扩展

而在Agentic AI阶段,关键指标发生迁移:

端到端延迟

资源调度效率

内存一致性

多任务并行能力

系统可靠性

技术焦点由“芯片峰值算力”转向“系统时延模型”。智能体的运行链路——感知、推理、规划、执行——呈现高度交互式结构,任何调度瓶颈都会指数级放大延迟成本。因此,算力竞争从单点性能,升级为体系结构重构。

从微观架构角度看,智能体任务包含大量:

数据预处理

Token解析

分支判断

调度与调用

I/O交互

这些属于:

高分支预测密集型

强缓存依赖型

低批量实时计算

GPU基于SIMT架构,擅长规则化并行矩阵运算;但在小批量、分支复杂、控制流频繁变化的场景下,其效率显著下降。

CPU则具备:

更高IPC

多级缓存体系

强分支预测

低延迟内存访问

因此,在端到端智能体系统中,CPU成为任务调度与控制流处理的核心中枢,延迟占比高达80%-90%,这并非阶段性现象,而是体系结构特性决定的结果。

在多模型协作场景下,数据交换成为主要瓶颈。传统PCIe结构存在:

数据复制开销

内存孤岛

带宽竞争

数据移动的能耗往往高于计算本身。

CXL(Compute Express Link)的引入,使CPU成为内存一致性控制核心,通过构建共享内存池,实现:

CPU与GPU缓存一致

减少数据重复拷贝

降低跨设备通信延迟

这一改变的意义在于优化“数据路径”而非单纯提升算力。其结果是系统级TCO下降,资源利用率提升。

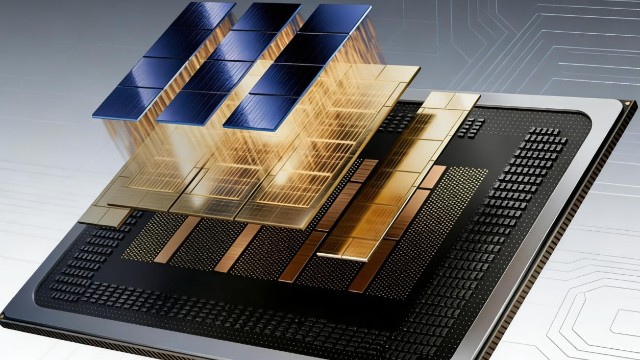

至强6的技术特征体现为结构性强化,而非单点参数提升。

I/O能力提升

192条PCIe 5.0通道意味着更高GPU接入密度与更强扩展能力。AI服务器往往先遭遇I/O瓶颈而非算力瓶颈,I/O增强等同于系统扩容能力提升。

核心密度与并发调度

单CPU最高128核心,支持更高容器密度与更强虚拟化能力。在Kubernetes环境中,核心数量直接决定资源分配粒度。

MRDIMM与内存带宽

带宽提升2.3倍,有效缓解Memory Wall问题。大模型推理与向量数据库高度依赖内存访问效率,带宽升级提升稳定性与QoS控制能力。

AMX矩阵扩展

AMX使CPU具备本地矩阵计算能力,小规模AI任务无需GPU即可完成,提升整体能效比,降低GPU调用频率。

RAS可靠性支持

企业级AI系统要求7×24小时运行,遥测与平台监控能力降低停机风险,提高运维效率。

至强6+基于更先进制程打造微型化计算单元,在提升性能的同时优化能效比。

其意义在于:

降低单位算力成本

提升数据中心能效

维持高核心密度下的功耗可控

在电力成本与碳排放压力上升背景下,能效优势正在成为服务器选型的重要决策因素。

GPU的重要性并未下降,而是角色再定义。

Crescent Island面向推理与边缘场景,强调能效与实时响应;

Jaguar Shores整合HBM3/4,面向高端训练任务。

关键变化在于:

GPU不再独立主导

必须与CPU调度体系深度协同

通过统一平台降低架构复杂度

算力竞争由“GPU峰值对标”转向“CPU+GPU协同效率”。

ASIC的优势在于极致能效比和场景优化,但缺乏通用性。

当规模足够大、场景足够稳定时,ASIC能够降低长期运营成本。

由此形成三级结构:

CPU:主控与调度

GPU:通用加速

ASIC:场景极致优化

这是兼顾灵活性与规模经济的最优解。

企业IT系统拥有庞大历史资产。若架构更换需要重写代码,则迁移成本与风险急剧上升。

至强6保持x86二进制兼容,意味着:

无需重构核心系统

可平滑嵌入AI能力

降低试错成本

从产业经济学视角看,这构成迁移成本壁垒,是长期竞争力的重要来源。

未来算力竞争呈现三重转变:

从FLOPS竞争转向系统延迟竞争

从单芯片优化转向资源调度优化

从硬件参数对比转向平台生态整合

真正的核心不在于谁拥有最多算力,而在于谁能够:

最高效调度算力

最低成本利用算力

在高可靠性下稳定运行

Agentic AI推动算力需求从“并行峰值”走向“协同效率”。

CPU重新回到舞台中央,是体系结构演进的必然结果。

英特尔以至强为核心,通过:

CXL优化数据路径

AMX强化本地计算

I/O扩展提升规模能力

GPU与ASIC形成异构矩阵

x86生态降低迁移成本

构建了系统级算力能力。

在智能体规模指数级扩张的未来,算力竞争已从“芯片性能之争”升级为“架构与协同之争”。

决定胜负的,不是单点峰值,而是整体效率。

咨询热线

400-000-8093